Hallo Holger

nimm doch mal einen anderen Controller. IDE ist ja nun wirklich weit von

der Wahrheit entfernt, oder?

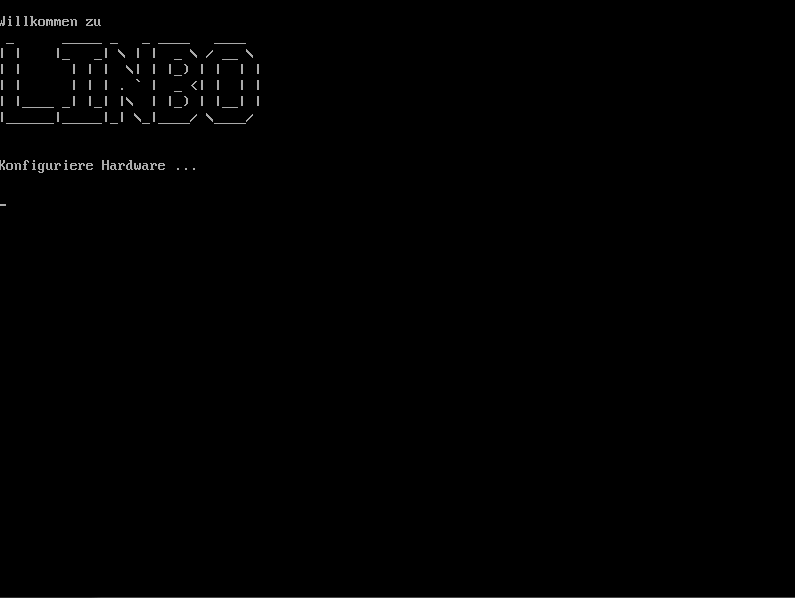

ich habe auch schon virtio genommen, gleiches Ergebnis.

Es geht dann

aber trotzdem (mit als auch ohne Tastendruck) weiter.

er läd es also dann über das Netz.

so weit so gut

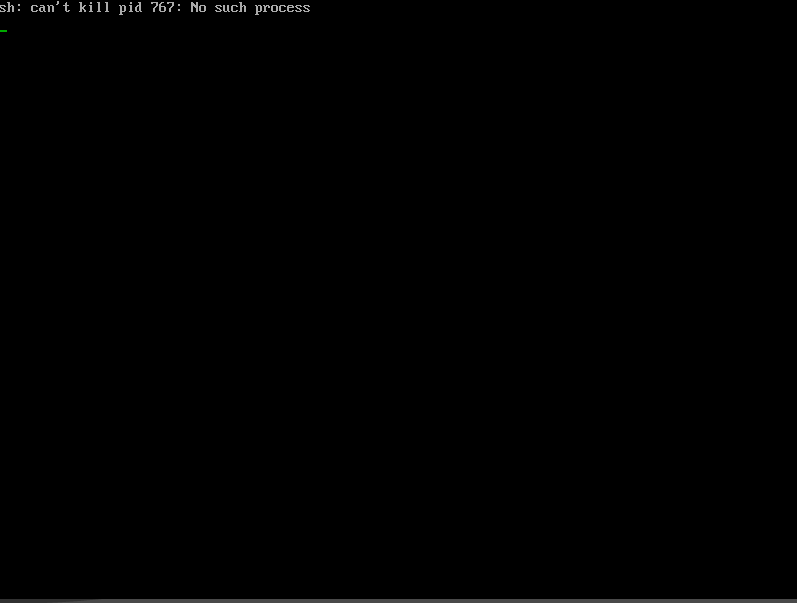

Allerdings kommt dann

|sh: can't kill PID 767: No such process|

und dann geht nichts mehr weiter.

allerdings geht halt danach nichts mehr weiter (s.o)

Spiele ich das Backup der VM mit der alten Disk (50GB) wieder ein,

bootet Linbo wieder einwandfrei :confused:

backup?

ja, ich habe ein Backup der VM von 2015 rumfahren, das ich inzwischen

schon ein paar Mal zurück gespielt habe. Danach geht der Linbo-Start wieder.

Hast du eine komplett neue VM erstellt, oder, wie es erst suggeriert

wurde, nur die Festplatte getauscht?

Ich habe schon alles Mögliche gemacht.

-

bei der vorhandenen (bis dahin per Linbo bootenden) VM die virtuelle HD

a) gelöscht und eine neue (bis auf die Größe identische) HD angelegt

b) die bisherige HD deaktiviert (nicht gelöscht) und eine neue (bis auf

die Größe identische) HD angelegt

c) eine HD als virtio statt ide angelegt

d) eine HD als qcow2 statt raw angelegt

e) alle Kombinationen aus c) und d) probiert

-

eine komplett neue VM erstellt mit

a) identischen Einstellungen zur bisherigen VM (selbst HD-Config und

Größe identisch)

b) allen Kombis aus 1.c) und d)

In keinem der Fälle bootet Linbo noch, es kommt immer der

sh: can’t kill PID 767: No such process

Fehler.

Selbst wenn ich in der bis dato funktionierenden (zurückgespielten) VM

die HD einmal deaktiviere und dann wieder aktiviere, bootet Linbo nicht

mehr (obwohl ja alle Daten auf der HD inkl. Cache noch drauf sind).

Das ist echt strange, dass Linbo mit der vorhandenen (alten) virtuellen

HD problemlos zurecht kommt, aber sobald man die einmal von

Hypervisor-Seite angefasst hat, Linbo nicht mehr bootet.

Noch stranger allerdings:

Lasse ich die (funktionierende) HD (von Linbo selbst!!) neu formatieren

und boote dann neu, funktioniert Linbo wieder nicht mehr?!?

Damit wurde ja hypervisor-seitig gar nichts verändert…

Da stellt sich schon die Frage:

Kann mein (aktuellstes) Linbo mit unformatierten oder von sich selbst

formatierten HDs nicht umgehen?!?

Seit ich das aktuelle Linbo installiert habe, habe ich definitiv nie

eine HD partitionsmäßig angefasst, so dass (mir) das Problem eventuell

nur noch gar nicht aufgefallen ist.

Ich will jetzt natürlich nicht einen benötigten Realclient

partitionieren und danach vor demselben Problem stehen…

Aber zurück zur Frage: welches einschneidende und äußerst verwüstende

Problem mit dem 16.04 cloop hast du den?

Muss ja was anderes sein als in der Mail von vorhin: das sah mir nicht

nach GAU aus.

Na ja, ich habe gestern ziemlich lange damit verbracht, mein virtuellen

Win aus Leoclient 1 in 2 zu bringen und auch sonst einige Änderungen

gemacht (neue Starter-Icons, …). Diese Arbeit war mal wieder für die

Tonne, wenn ich auf’s alte Cloop zurück muss. So was nervt (mich)

einfach kolossal, wenn ich sinnlos Zeit verplempere(n muss).

Viele Grüße

Steffen

![]()

![]()